【Anandtech】NVIDIA揭晓Volta架构:发布GV100 GPU及Tesla V100加速卡

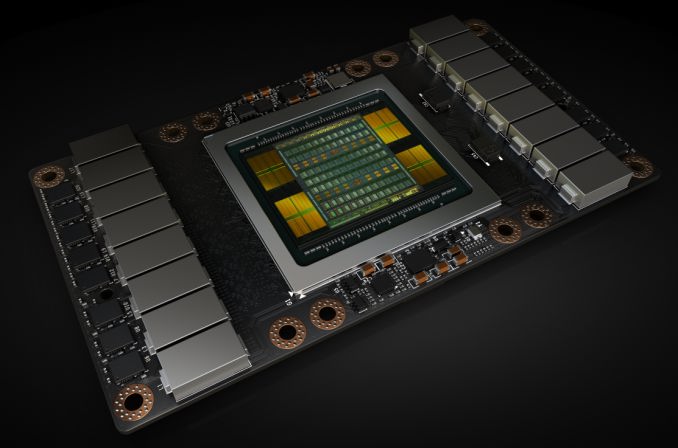

今天在GTC大会上,NVIDIA CEO黄仁勋发布了首款Volta架构的GPU – GV100以及产品 – Tesla V100加速卡。NVIDIA这次用Tesla V100瞄准超高端计算市场,同时准备用非常激进的策略带来GPU深度学习性能的一次飞跃。

NVIDIA首次提到Volta架构是在2013年。结果到后来路线图改动,Maxwell→Volta变成了Maxwell→Pascal→Volta ?? 且Volta是目前NVIDIA公开的路线图中的最后一款架构。

作为Volta架构的首款产品,NV采取了和去年Pascal相似的策略:用HPC和深度学习等商业领域的产品打头阵,而不是消费级GPU。Volta是面向计算和显示两方面的架构,但今天的发布都针对的是前者。因此今天揭晓的各种功能以及首款Volta GPU的重心都在计算上。

NVIDIA的首款Volta GPU代号为GV100。作为Pascal GP100的继任者,GV100是NV在计算方面的旗舰GPU,负责驱动下代Tesla加速卡。

在开始之前,在这里要先明确一点:在各个方面上,Volta都是一款全新的架构。虽然内部看起来差不多,但它绝对不是Pascal换12nm工艺加上新核心(Tensor Core),而是完全不同的架构,比如线程执行、线程调度、核心设计、内存控制器、指令集架构等方面。这些只是NV公开的部分,还有很多没有揭晓的秘密。所以今天只能做到浅谈。

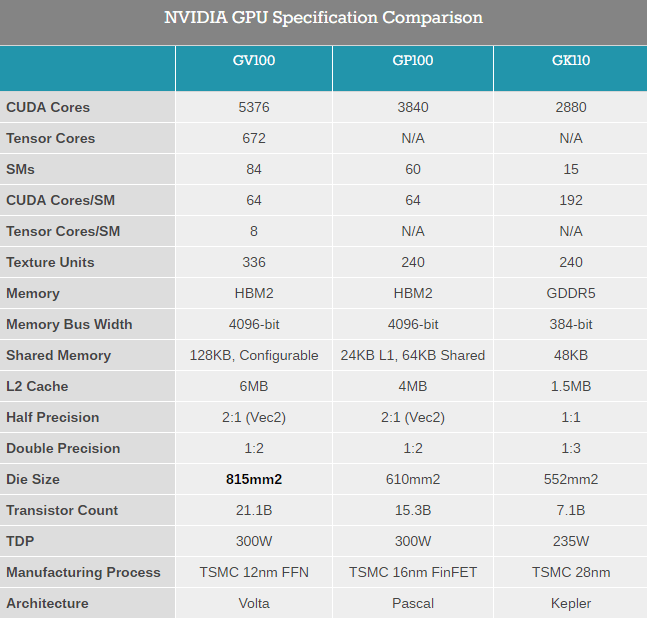

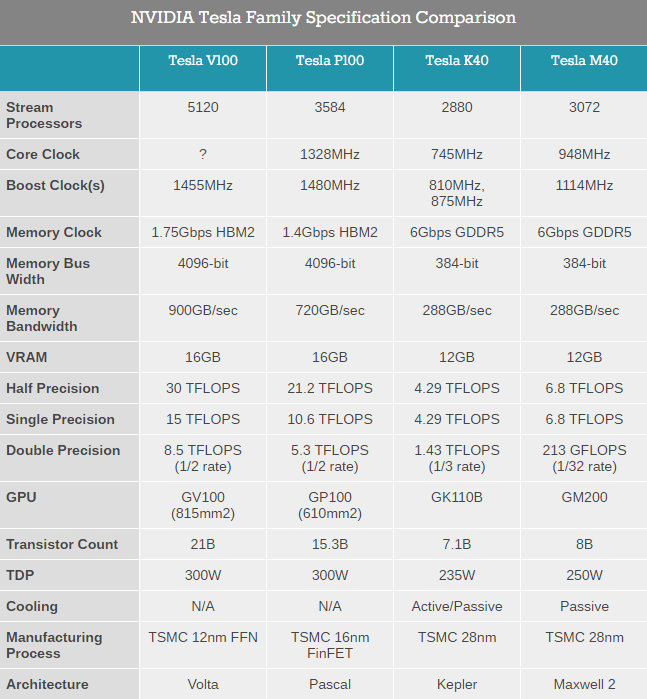

从规格上来讲,说实话GV100是一款非常大胆的GPU,我没用过这个词形容过去10年的任何一款GPU。在核心面积和晶体管数量方面,NV已经做到了极限:211亿晶体管,815平方毫米,基于台积电尚未成熟的12nm FFN制程(”N”代表NVIDIA,12FFN是专为NVIDIA定制的高性能版本12nm工艺)。

NV的前代巨无霸是610平方毫米的GP100,GV100虽然用了新制程,依然要比它大33%。实际上NV这次直接向着台积电12FFN制程光罩的大小;GV100是台积电所能制造的最大GPU。NV对光罩大小并不陌生,GM200就是台积电28nm制程下所能制造的最大GPU,虽然只有601平方毫米。

为什么要首先谈核心大小?总的来说,核心大小和性能有很大关系。但更重要的是,核心大小标志着NV是如何挑战极限的。这次NV没有提到良率,但都知道这么大的芯片良率肯定会非常差,还是在新的12FFN制程上。这次NV要牺牲很多良率,才能给饥渴的客户以15000刀一颗的价格提供少量的成品。NV的客户就是这么地渴望更强大的GPU,NV把制程用到极限正是如此地艰难。

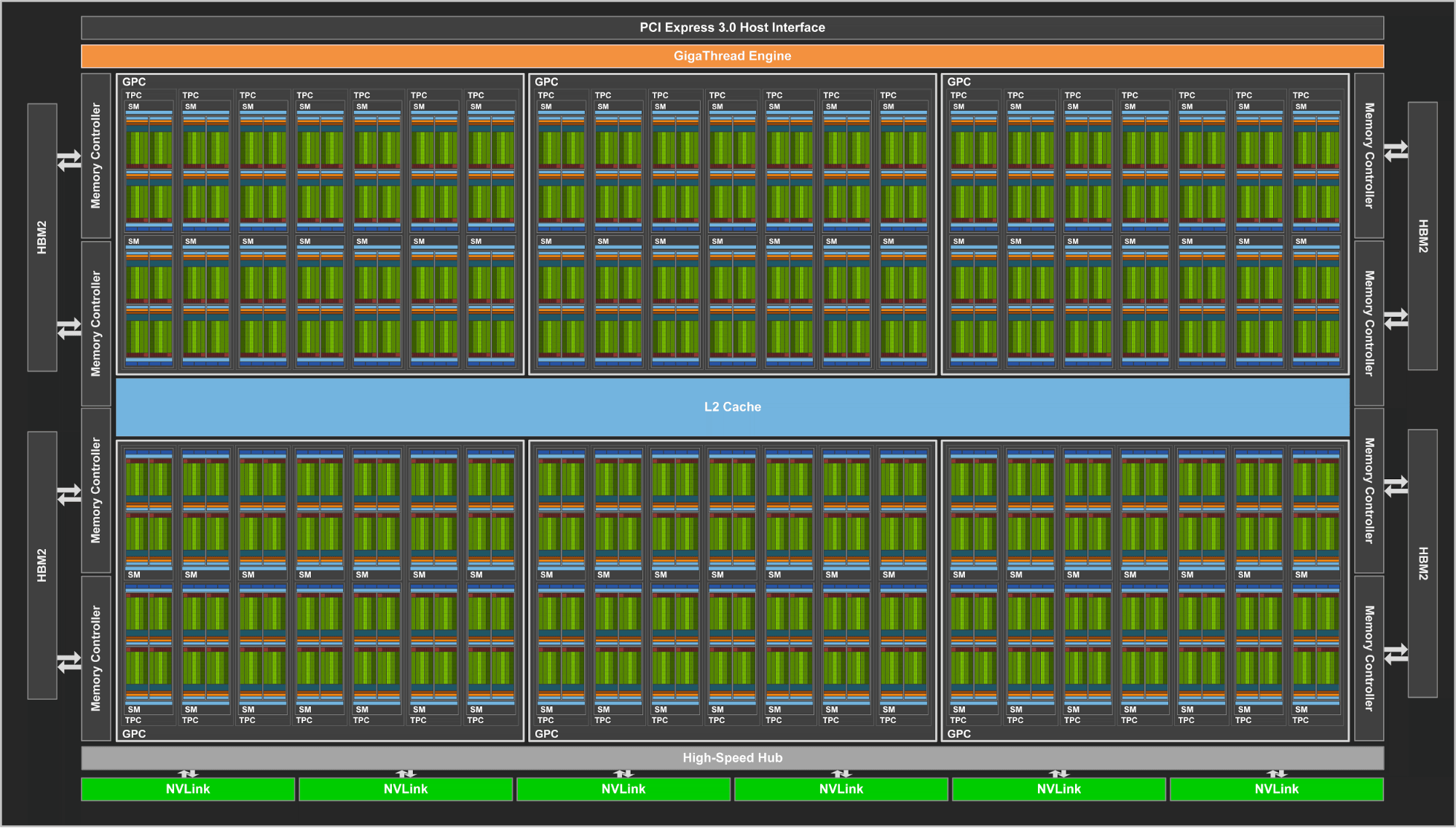

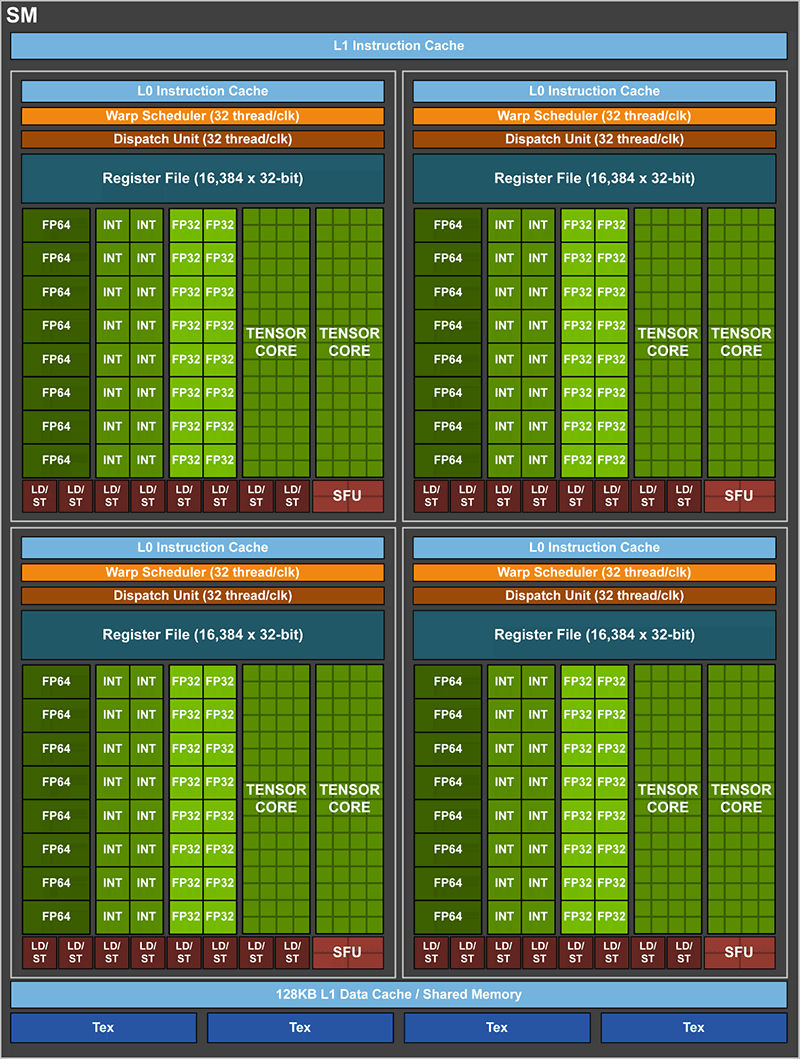

GV100非常强大,包含84个SM,由于GV100是计算用的核心,所以每个SM有64个CUDA核心 – 总共5376个FP32 CUDA核心。同时还有2688个FP64 CUDA核心,以及新的Tensor Core。

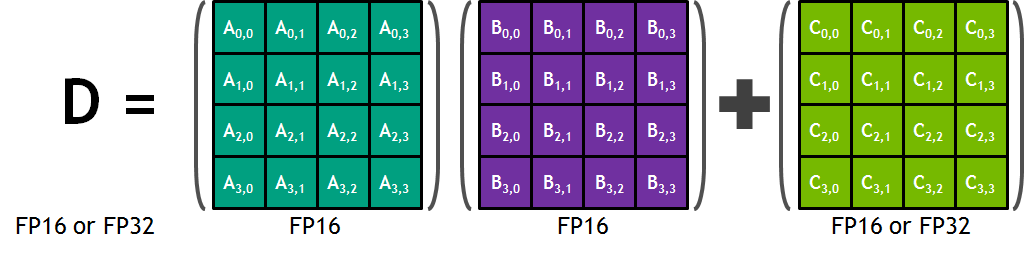

Tensor Core是Volta上的新核心,灵活性较差(依然可编程),专为Tensor深度学习操作所设计。基本来说,Tensor Core就是一堆专为处理4×4矩阵操作的ALU;特别是融合乘加,也就是将两个4×4 FP16矩阵相乘,然后把结果加到一个FP16/FP32 4×4矩阵上,生成最终的4×4 FP32矩阵。

有了这些Tensor Cores,NV可以用一次操作达成超高的FLOPS数。一个Tensor Core每周期可以执行相当于64 FMA操作(共128FLOPS),1个SM有8个Tensor Core,也就是每个SM 1024FLOPS。作为对比,即便是纯FP16,1个SM里的所有标准CUDA核心也只有256FLOPS。所有如果这些核心能够用上,NV可以达到Pascal的四倍性能。

现在还有一些未知因素,包括Tensor Cores到底灵活度如何,核心面积占了多少等。总的来说Tensor Cores会比较死板,面积利用效率会比较高。NV把这么多核心打包成一个核心,不需要增加控制逻辑和其他的辅助硬件, 每个核心分到的晶体管数就会比标准CUDA核心要多。代价是灵活性,因为越灵活需要的芯片面积就越大。这是NV在灵活度和总输出之间有意做出的权衡。

每个SM包含4个材质单元,与GP100相同。一起的还有新的L1缓存/共享内存架构。GP100的1个SM有24KB L1/材质缓存 + 64KB共享内存,而GV100上变成统一的128KB L1数据缓存/共享内存(增加了40KB),可以精确配置L1和共享内存的容量。而寄存器依然还是256KB(4x16K 32bit)

84个SM,和GP100一样,2个SM组成1个TPC;共42个TPC。7个TPC组成1个GPC,一共6个GPC。显存还是用的HBM2,与GP100相同的4 stack。虽然内存频率只提升了25%,Volta还有内存效率的改善,NV称等效带宽提升了50%。在GPC和显存之间的L2缓存也被加强,每个ROP现在有768KB L2,GP100上是512KB。这意味着GV100共有6MB L2。

Volta还带来了新版本的NVLink,之前发布时称为NVLink 2,单向带宽提升5GB/s,来到25GB/s。GV100有6条NVLink,比GP100多2条。至关重要的是,NVLink 2引入了缓存一致性,允许GPU和CPU缓存一致,这在Power 9 + Volta系统上会很重要。

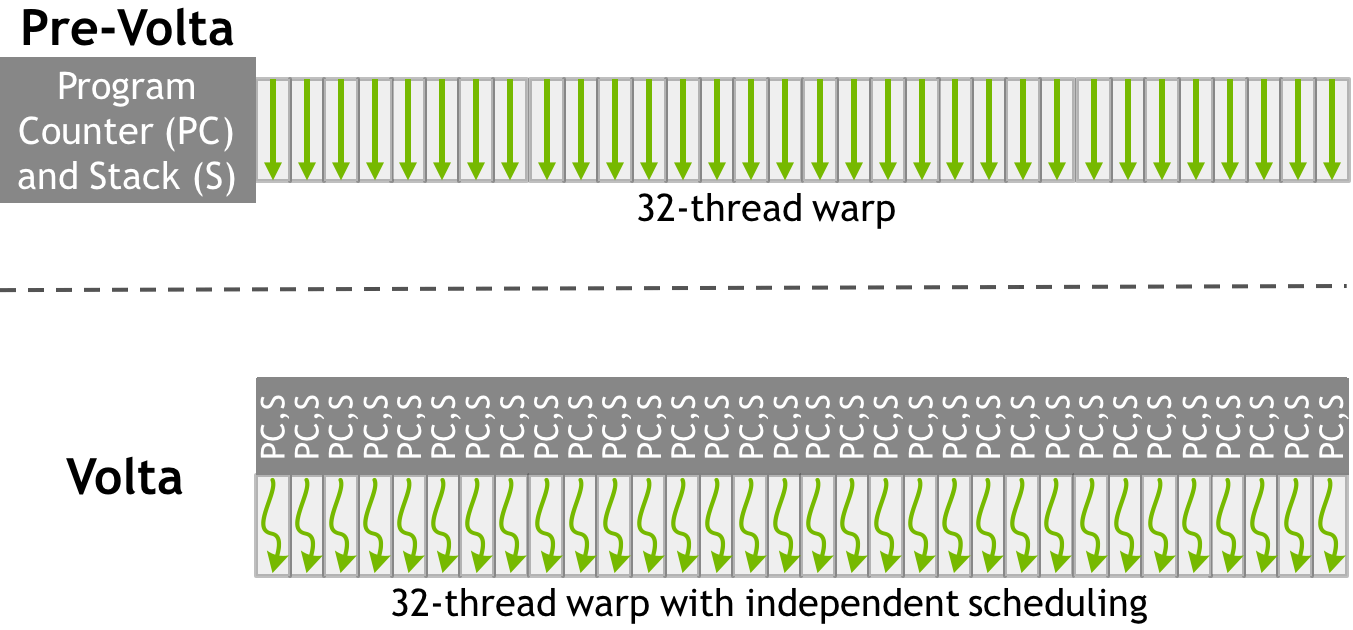

NV也揭晓了Volta上SIMT工作方式的巨大改变。在一个32-thread warp内的CUDA核心现在有了一定的自由度;可以在细粒度级别同步线程,同时保持良好SIMT范式,这意味着更高的总体效率。重要的是,单独的线程现在可以yield,然后再重新调度到一起。这也意味着NV GPU上回归了一部分的硬件调度。

作为30亿刀R&D砸出来的项目,GV100是NV目前为止最大的项目所打造的最大的GPU。NV估计首批GV100将在今年Q3出货,而且不便宜 – DGX系统上18000刀一颗 – 但对于那些肯掏钱帮助NV消化风险的客户来说,这是目前为止最强大的GPU。

Tesla V100

首款搭载GV100的产品是Tesla V100。与前辈P100一样,依然不是完整版。基于良率上的考虑,只开了84个SM中的80个。

Tesla V100能提供15TFLOP的FP32单精度性能,30TFLOPS的FP16半精度性能,7.5FLOPS的FP64双精度性能,以及惊人的120TLOPS独立Tensor操作量。频率为1455MHz的V100带来了42%的理论FLOPS提升(CUDA核心)。而Tensor操作方面提升会达到6-12倍,取决于操作精度。

V100采用16GB HBM2显存。目前还没有厂商生产8层堆叠,所以4stack的显存就只能这么多。显存频率从P100的1.4Gbps提升到了1.75Gbps。

与P100一样,这次V100也用的是SXM2,针脚应该会更多,体积上相近。

功耗方面,V100 TDP为300W,与前代一致。NV说V100的能效高于P100。

搭载V100的首个出货产品会是NVIDIA DGX-1V,Volta版的DGX,内含8颗V100,价格149000刀,Q3出货,OEM则Q4之前都不会到来。

NV也发布了两款PCIe版的V100,一个是250W的完整尺寸卡,一个是更小的全高半长卡,称为”Tesla V100 for Hyperscale Inference”,这张150W,专为数据中心推理服务器的高密度配置,估计频率和规格都会有所降低。

via:anandtech

作者:Ryan Smith

本站编译,转载请注明出处。